Les journalistes doivent donner la parole aux communautés sous-représentées et défavorisées qui sont victimes d’une grande partie de la désinformation qui alimente les récits polarisants et sape la confiance dans la démocratie elle-même, écrit Meera Selva.

2024 sera l’année des élections motivées par des campagnes électorales renforcées par l’IA, des conflits mondiaux et des outils d’IA toujours plus omniprésents.

Quelque 2 milliards de personnes se rendront aux urnes lors de 65 élections pour sélectionner des dirigeants qui auront fait campagne, communiqué et collecté des fonds en ligne, et qui savent que leur mandat sera défini par l’espace numérique.

Le vote aura lieu dans certains des pays les plus densément peuplés du monde, où les médias ont été bouleversés par les communications numériques, notamment en Indonésie, en Inde et au Mexique.

Et ces élections seront parmi les premières à avoir lieu après la soudaine popularisation des technologies d’IA générative, ce qui jette encore plus d’incertitude sur leur déroulement.

Certains soutiennent que les craintes suscitées par l’IA sont exagérées et que la plupart des gens ne verront pas leur comportement modifié par l’exposition à la désinformation générée par l’IA. 2024 offrira des preuves permettant de savoir si cela est vrai ou non.

Les petits groupes joueront un grand rôle. Les élections sont désormais souvent si disputées que les résultats finaux peuvent, proportionnellement, être modifiés par très peu d’électeurs.

La méfiance ou l’hostilité à l’égard d’un petit groupe peut finir par définir l’ensemble du débat national. Les communautés de couleur et les communautés immigrées peuvent être affectées de manière disproportionnée par la désinformation en période électorale, à la fois par les théories du complot qui sapent leur confiance dans le processus et par les informations incorrectes sur la manière de voter.

C’est pourquoi les besoins et les voix des communautés minoritaires doivent être au premier plan lors de ces élections. La question de savoir si les outils d’IA aideront ou gêneront cela reste une question ouverte.

Aucun contrôle éditorial ne fera qu’empirer les choses

Certains des plus grands dangers que les technologies d’IA largement accessibles poseront lors des élections mondiales proviennent du manque de diversité dans la conception et le leadership.

Il existe déjà une tendance à la propagation de la désinformation via des erreurs de traduction – des mots qui ont des connotations différentes, souvent plus négatives, lorsqu’ils sont traduits d’une langue, généralement l’anglais, à une autre.

Cette situation ne fera qu’empirer si les traductions basées sur l’IA sont effectuées rapidement, sans contrôle éditorial ni surveillance de la part des locuteurs natifs.

Certains outils d’IA jouent également sur les préjugés existants à l’égard des minorités : lors des élections slovaques de cet automne, un prétendu enregistrement audio d’un candidat parlant à un journaliste d’un projet visant à acheter des voix à la minorité rom, qui est structurellement discriminée et souvent considérée avec hostilité, s’est répandu vite sur Facebook.

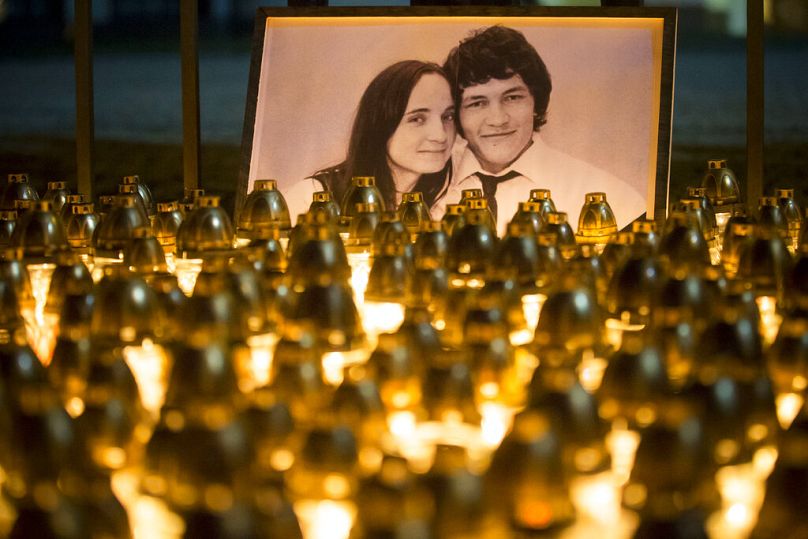

La vérité selon laquelle l’enregistrement avait été altéré est arrivée trop tard : le candidat en question, Michal Simecka, a perdu face à l’ancien Premier ministre Robert Fico, revenu au pouvoir après avoir démissionné en 2018 suite à l’indignation suscitée par le meurtre d’un journaliste d’investigation.

Utiliser la technologie pour continuer à discriminer les autres

En Inde, on craint que les outils d’IA populaires ne renforcent la discrimination existante fondée sur la caste, la religion et l’origine ethnique.

Lors des émeutes communautaires à Delhi en 2020, la police a utilisé la technologie de reconnaissance faciale basée sur l’IA pour arrêter les émeutiers. Les critiques soulignent que la technologie est plus susceptible d’être utilisée contre les musulmans, les communautés autochtones et ceux de la caste des Dalits à l’approche des élections dans le pays.

Ces craintes sont étayées par des recherches de l’Université Queens de Belfast, qui ont montré d’autres façons par lesquelles l’utilisation de l’IA dans les processus électoraux peut nuire aux minorités.

Si la technologie est utilisée pour gérer les listes de diffusion ou pour décider de l’emplacement des bureaux de vote, le risque est réel que les groupes minoritaires soient ignorés ou mal servis.

De nombreux problèmes liés à la diversité du contenu généré par l’IA proviennent des ensembles de données sur lesquels la technologie est formée, mais les caractéristiques démographiques des équipes d’IA sont également un facteur.

Un rapport McKinsey sur l’état de l’IA en 2022 montre que les femmes sont considérablement sous-représentées, et un chiffre choquant de 29 % des personnes interrogées ont déclaré qu’aucun employé appartenant à une minorité ne travaillait sur leurs solutions d’IA.

Comme l’a récemment souligné le Dr Sasha Luccioni, chercheuse en IA, les femmes sont même exclues des rapports sur l’IA.

L’IA présente également des avantages

Il est clair que l’IA jouera un rôle important lors des élections de l’année prochaine. Une grande partie de ces informations seront bénéfiques : elles peuvent être utilisées pour alimenter les chatbots afin d’impliquer les citoyens dans les processus politiques et peuvent aider les candidats à comprendre plus facilement les messages de la campagne électorale.

Je le constate personnellement dans mon travail quotidien : Internews s’associe à des médias locaux et indépendants du monde entier qui utilisent de manière créative les outils d’IA pour améliorer l’accès du public à de bonnes informations.

Au Zimbabwe, le Centre pour l’innovation et la technologie utilise un avatar généré par l’IA comme lecteur de nouvelles en temps réel, dont le discours peut être adapté aux accents et dialectes locaux, atteignant ainsi des communautés rarement représentées dans les salles de rédaction.

Et ailleurs en Afrique, les rédactions utilisent des outils d’IA pour détecter les préjugés et la discrimination dans leurs articles.

Les mêmes outils d’IA seront presque certainement utilisés par des acteurs malveillants pour générer des contrefaçons profondes, alimenter la désinformation et fausser le débat public à une vitesse fulgurante.

Les Philippines, par exemple, ont vu leur discours politique bouleversé par les médias sociaux, au point que leur rédactrice en chef la plus célèbre, Maria Ressa, lauréate du prix Pulitzer, a averti que les Philippines étaient le canari dans une mine de charbon à l’interface de la technologie, communications et démocratie; tout ce qui s’y passe se produira dans le reste du monde d’ici quelques années.

Il y a cependant des réticences et la société philippine passe à l’action : à l’approche des élections de l’année prochaine, les organisations de médias et la société civile se sont réunies pour créer des cadres éthiques en matière d’IA comme point de départ sur la manière dont les journalistes peuvent utiliser cette nouvelle technologie de manière responsable.

Donner la parole à ceux qui reçoivent reste vital

Mais ces types d’initiatives ne constituent qu’une partie de la solution. Le journalisme ne peut à lui seul résoudre les problèmes posés par l’IA générative et programmée lors des élections, de la même manière qu’il ne peut pas résoudre les problèmes de désinformation.

C’est une question sur laquelle les régulateurs, les entreprises technologiques et les commissions électorales doivent travailler aux côtés des groupes de la société civile – mais cela ne suffira pas non plus.

Il est essentiel que les journalistes donnent la parole aux communautés sous-représentées et défavorisées qui sont victimes d’une grande partie de la désinformation qui alimente des discours polarisants et sape la confiance dans les élections et, en fin de compte, dans la démocratie elle-même.

Nous n’avons pas prêté suffisamment d’attention aux communautés mal desservies et aux groupes minoritaires lorsque les médias sociaux ont pour la première fois bouleversé les processus électoraux dans le monde entier, contribuant ainsi au recul démocratique et à la division que nous observons aujourd’hui. Ne commettons pas deux fois la même erreur.