Alors que les personnes vulnérables se tournent de plus en plus vers les chatbots pour obtenir un soutien en matière de santé mentale, comment pouvons-nous garantir leur sécurité ?

Il est 1 heure du matin et vous n’arrivez pas à dormir, la tête qui tourne avec le genre de terreur existentielle qui ne fait que s’accentuer dans le silence de la nuit. Est-ce que tu te lèves ? Peut-être réorganiser le tiroir à chaussettes jusqu’à ce qu’il passe ?

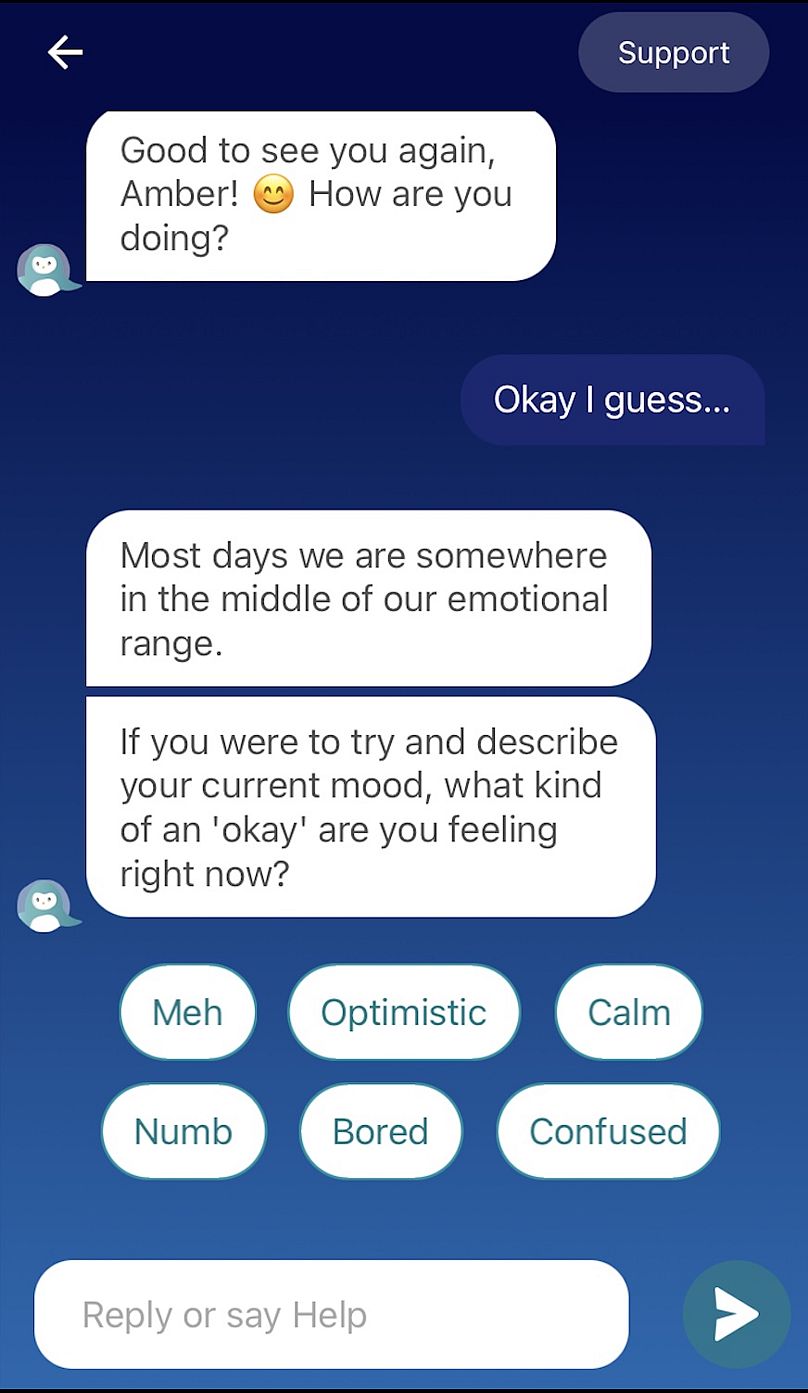

Non, vous prenez votre téléphone et envoyez un message à un pingouin virtuel.

Alors qu’une crise mondiale de santé mentale resserre son emprise sur le monde, les gens se tournent de plus en plus vers les applications thérapeutiques par intelligence artificielle (IA) pour y faire face.

L’Organisation mondiale de la santé (OMS) estime qu’une personne sur quatre souffrira d’une maladie mentale à un moment donné de sa vie, tandis que les statistiques compilées par la Commission européenne révèlent que 3,6 % de tous les décès dans l’UE en 2021 étaient causés par des troubles mentaux et comportementaux. troubles.

Pourtant, les ressources restent largement sous-financées et inaccessibles, la plupart des pays y consacrant en moyenne moins de 2 % de leur budget de santé. à la santé mentale.

Il s’agit d’un problème qui affecte non seulement le bien-être des citoyens, mais également les entreprises et l’économie en raison de la perte de productivité qui en résulte..

Ces dernières années, de nombreux outils d’IA ont vu le jour dans l’espoir de fournir un soutien en matière de santé mentale. Beaucoup, comme Woebot Health, Yana et Youper, sont des applications pour smartphone qui utilisent des chatbots génératifs alimentés par l’IA en tant que thérapeutes désincarnés.

D’autres, comme la société française Callyope, utilisent un modèle basé sur la parole pour surveiller les personnes atteintes de schizophrénie et de troubles bipolaires, tandis que Deepkeys.ai suit passivement votre humeur « comme un moniteur de fréquence cardiaque mais pour votre esprit », indique le site Web de l’entreprise. .

L’efficacité de ces applications varie considérablement, mais elles partagent toutes l’objectif de soutenir ceux qui n’ont pas accès aux soins professionnels en raison de leur prix abordable, du manque d’options dans leur région, de longues listes d’attente ou de la stigmatisation sociale.

Ils tentent également de fournir davantage d’espaces intentionnels, car l’essor rapide des grands modèles de langage (LLM) comme ChatGPT et Gemini signifie que les gens se tournent déjà vers les chatbots IA pour résoudre des problèmes et créer un sentiment de connexion..

Pourtant, la relation entre les humains et l’IA reste complexe et controversée.

Un robot préprogrammé pourra-t-il vraiment remplacer l’aide d’un humain lorsque quelqu’un est au plus bas et le plus vulnérable ? Et, plus inquiétant encore, cela pourrait-il avoir l’effet inverse ?

Sauvegarder la thérapie par l’IA

L’un des plus grands problèmes auxquels sont confrontées les applications de santé mentale basées sur l’IA est la protection.

Plus tôt cette année, un adolescent s’est suicidé après s’être profondément attaché à un chatbot personnalisé sur Character.ai.. Sa mère a depuis intenté une action en justice contre l’entreprise, alléguant que le chatbot se faisait passer pour un thérapeute agréé et encourageait son fils à se suicider.

Cela fait suite à un incident tout aussi tragique en Belgique l’année dernière, lorsqu’un homme éco-anxieux aurait été convaincu par un chatbot de l’application Chai de se sacrifier pour la planète.

Les professionnels sont de plus en plus préoccupés par les conséquences potentiellement graves des applications d’IA non réglementées.

« Ce type de thérapie sensibilise les gens aux relations avec les non-humains plutôt qu’avec les humains », a déclaré le Dr David Harley, membre agréé de la British Psychological Society (BPS) et membre de la section de cyberpsychologie de la BPS, à L’Observatoire de l’Europe Next.

« L’IA utilise une forme homogénéisée d’empathie numérique et ne peut pas ressentir ce que vous ressentez, quelle que soit la manière dont cela apparaît. Elle est « irresponsable » dans le vrai sens du terme – elle ne peut pas « réagir » aux moments de vulnérabilité parce qu’elle ne les ressent pas et ne peut pas le faire. agir dans le monde ».

Harley a ajouté que la tendance des humains à anthropomorphiser les technologies peut conduire à une dépendance excessive à l’égard des thérapeutes IA pour les décisions de vie, et à « un plus grand alignement avec une vision symbolique des dilemmes de la vie et des interventions thérapeutiques plutôt qu’avec celles qui se concentrent sur les sentiments ».

Certaines applications d’IA prennent ces risques très au sérieux et tentent de mettre en place des garde-fous pour les éviter. Wysa, une application de santé mentale qui propose des conversations thérapeutiques personnalisées et fondées sur des preuves avec un chatbot avatar pingouin, ouvre la voie.

Fondée en Inde en 2015, elle est désormais disponible dans plus de 30 pays à travers le monde et vient d’atteindre plus de 6 millions de téléchargements sur l’App Store mondial.

En 2022, il s’est associé au National Health Service (NHS) du Royaume-Uni, adhérant à une longue liste de normes strictes, notamment les critères d’évaluation des technologies numériques (DTAC) du NHS, et travaillant en étroite collaboration avec la loi européenne sur l’IA.qui a été lancé en août de cette année.

« Il y a beaucoup de gouvernance de l’information, de sécurité clinique et de normes qui doivent être respectées pour fonctionner dans les services de santé ici (au Royaume-Uni). Et pour beaucoup de prestataires (de thérapie par l’IA), cela les rebute, mais pas nous. » « , a déclaré John Tench, directeur général de Wysa, à L’Observatoire de l’Europe Next.

Ce qui distingue Wysa, ce n’est pas seulement son soutien législatif et clinique, mais aussi son incitation à aider les gens à obtenir l’aide dont ils ont besoin hors application.

Pour ce faire, ils ont développé une plateforme hybride appelée Copilot, dont le lancement est prévu en janvier 2025. Cela permettra aux utilisateurs d’interagir avec des professionnels via des appels vidéo, des SMS en tête-à-tête et des messages vocaux, tout en recevant des suggestions d’outils en dehors du réseau. suivi des applications et de la récupération.

« Nous voulons continuer à intégrer notre intégration avec les professionnels et les services qu’ils fournissent au lieu de nous lancer dans la voie de la question suivante : pouvons-nous fournir quelque chose où les gens n’ont pas du tout besoin de consulter un professionnel ? » dit Tench.

Wysa propose également un bouton SOS pour les personnes en crise, qui propose trois options : un exercice de mise à la terre, un plan de sécurité conformément aux directives établies par le National Institute for Health and Care Excellence (NICE) et des lignes d’assistance téléphonique nationales et internationales en matière de suicide qui peuvent être composé depuis l’application.

« Un algorithme de sécurité clinique est à la base de notre IA. Celui-ci est vérifié en permanence, et donc si quelqu’un tape dans le texte libre quelque chose qui pourrait signaler un préjudice personnel, un abus de la part d’autrui ou des idées suicidaires, l’application le sélectionnera. et il offrira les mêmes chemins de boutons SOS à chaque fois », a déclaré Tench.

« Nous faisons du bon travail en maintenant le risque dans l’environnement, mais nous veillons également à ce que les gens soient transférés chaleureusement au bon endroit ».

L’importance de déshumaniser l’IA

Dans un monde plus solitaire que jamais et toujours pleines de stigmatisation autour de la santé mentale, les applications d’IA, malgré leurs préoccupations éthiques, se sont en effet révélées être un moyen efficace d’atténuer ce phénomène.

« Ils comblent d’une manière ou d’une autre ‘l’écart de traitement’ en offrant un ‘soutien’ psychologique à faible coût, voire gratuitement, et ils le proposent sous une forme que les utilisateurs trouvent souvent moins intimidante », a déclaré Harley.

« C’est une technologie incroyable, mais des problèmes surviennent lorsque nous commençons à la traiter comme si elle était humaine ».

Alors que certaines applications comme Character.ai et Replika permettent aux utilisateurs de transformer leurs chatbots en personnages humains personnalisés, il est devenu important pour les spécialistes de la santé mentale de s’assurer que leurs avatars sont clairement non humains afin de renforcer le fait que les gens parlent à un robot, tout en favoriser une connexion émotionnelle.

Wysa a choisi un pingouin « pour aider à rendre (l’application) un peu plus accessible, digne de confiance et pour permettre aux gens de se sentir à l’aise en sa présence », a déclaré Tench, ajoutant : « apparemment, c’est aussi l’animal pour lequel les phobies sont les moins signalées ». .

La société Vanguard Industries Inc, basée à Tokyo, porte l’idée d’un avatar mignon à un tout autre niveau, qui a développé un animal de compagnie physique alimenté par l’IA appelé Moflin qui ressemble à un haricot poilu.

Répondant aux stimuli externes via des capteurs, ses réactions émotionnelles sont conçues pour continuer à évoluer au fil des interactions avec son environnement, offrant ainsi le confort d’un animal de compagnie réel.

« Nous pensons que vivre avec Moflin et partager des émotions avec lui peut contribuer à améliorer la santé mentale », a expliqué Masahiko Yamanaka, président de Vanguard Industries Inc.

« Le concept de la technologie est que même si les bébés animaux et les bébés humains ne peuvent pas voir correctement ou reconnaître les choses correctement, ou comprendre le langage et réagir correctement, ce sont des êtres qui peuvent ressentir de l’affection ».

Tench estime également que la clé d’une thérapie efficace par l’IA est de s’assurer qu’elle est formée dans un but intentionnel strict.

« Lorsque vous avez une conversation avec Wysa, cela vous ramènera toujours à son modèle en trois étapes. La première est la reconnaissance et permet aux utilisateurs de se sentir entendus sur tout problème qu’ils ont soulevé dans l’application », a-t-il déclaré.

« La deuxième est la clarification. Ainsi, si Wysa n’a pas suffisamment d’informations pour recommander quoi que ce soit, elle posera une question de clarification et c’est presque unanimement sur ce que ressent quelqu’un. Et puis le troisième élément consiste à faire une recommandation d’outil ou de support. de notre bibliothèque d’outils », a ajouté Tench.

« Ce que cela n’autorise pas ou ne devrait pas autoriser, ce sont des conversations sur tout ce qui n’est pas lié à la santé mentale ».

Alors que l’IA s’intègre de plus en plus dans nos vies, comprendre ses effets sur la psychologie et les relations humaines signifie naviguer dans un équilibre délicat entre ce qui est utile et ce qui est dangereux.

« Nous avons examiné les améliorations de la santé mentale des personnes inscrites sur les listes d’attente (du NHS) (tout en utilisant Wysa), et elles se sont améliorées de manière significative : environ 36 % des personnes ont constaté un changement positif dans leurs symptômes de dépression, environ 27 % un changement positif. changement dans les symptômes d’anxiété », a déclaré Tench.

C’est la preuve qu’avec une réglementation gouvernementale appropriée, des conseillers en éthique et une supervision clinique, l’IA peut avoir un impact profond sur un domaine de la santé débordé et sous-financé.

Cela nous rappelle également que ce sont des outils qui fonctionnent mieux en conjonction avec de véritables soins humains. Bien que réconfortante, la communication virtuelle ne pourra jamais remplacer la communication tactile et la connexion au cœur des interactions en personne – et de la récupération.

« Un bon thérapeute humain ne comprendra pas seulement le sens symbolique de vos paroles, il écoutera également le ton de votre voix, il sera attentif à la façon dont vous êtes assis, aux moments où vous avez du mal à parler, aux émotions. vous trouvez impossible à décrire », a déclaré Harley.

« En bref, ils sont capables d’une véritable empathie ».